Copilot+ PCやハイスペックマシンでお手軽ローカルLLM「LM Studio」を試してみた UIがかなり使いやすいぞ DeepSeekの小型モデルも動く

ビッグテック企業がサービスやAPI越しに提供している超巨大LLMがトレンドではあるものの、ローカルで実行できるサイズのLLMにも実はいろいろな変化が起こりつつある。そんな変化を手軽に実感できるアプリとして今回紹介したいのが「LM Studi...続きを読む

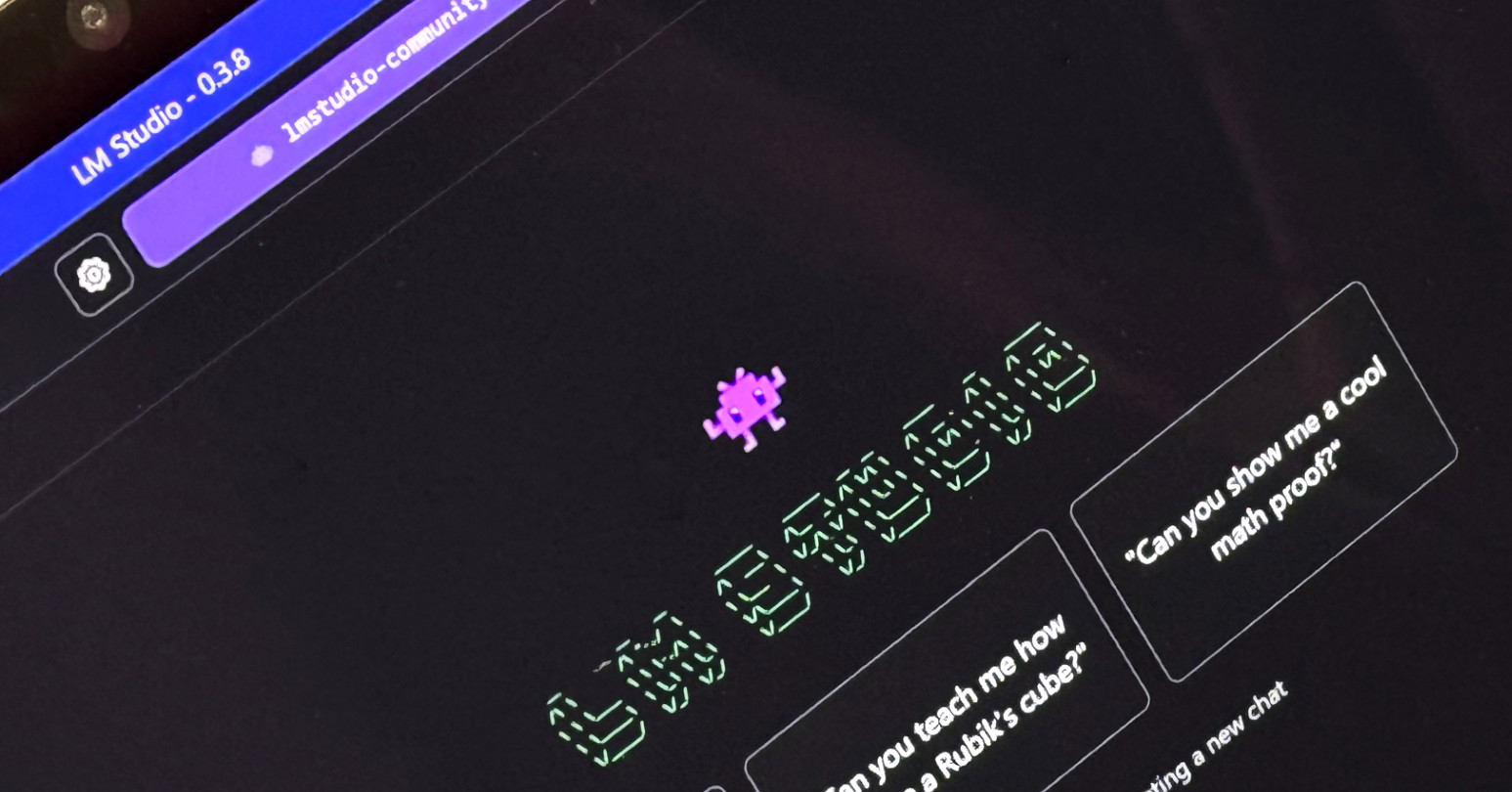

米Element Labsが開発したローカルLLM(大規模言語モデル)アプリケーション「LM Studio」は、ハイスペックなPCやノートPCで手軽にLLMを実行できる環境を提供します。

- LM Studioの特徴

- 対応OS: Mac、Windows、Linux

- Windows版はx64とARMをサポート

- GUIを通じてモデルのダウンロードから実行まで簡単に行える

- インストール手順

- 公式サイトからインストーラーをダウンロード

- インストーラーを起動し、指示に従ってインストール

- 初回起動時に「Llama 3.2 1B」モデルのダウンロードを提案される(約1.3GB)

- ユーザーインターフェース

- メインウィンドウにはチャット画面、デベロッパー画面、モデル一覧などの切り替えボタンが配置

- 言語設定は英語から日本語に変更可能

- モデルの選択と性能

- HuggingFaceから多様なLLMを検索・選択可能

- 各モデルには量子化オプションがあり、メモリに応じた適切なモデルが推奨される

- 例: メモリ16GBの環境では、DeepSeek R1 Distill(Llama 8B)のQ4モデルが推奨される

- 実行性能

- モデルによって性能が異なり、特定のタスクに適したモデルを選ぶことが重要

- 例えば、コーディングに特化した「Qwen2.5-Coder-7B-Instruct」は迅速にコードを生成する

- セキュリティとライセンス

- ローカルでの実行により情報漏洩のリスクが低減

- 各LLMにはライセンスがあり、利用シーンに制限があるため確認が必要

LM Studioは、PCのスペックとLLMの小型化技術の進展により、手軽にLLMを試すことができる環境を提供しています。特に、各モデルの特性を理解し、適切なモデルを選ぶことで、より効果的に利用できるでしょう。

LM Studio公式Webサイト https://lmstudio.ai/