iPhone 14で高速動作する軽量AIモデル、Sakana AIが開発 知識蒸留の新手法「TAID」採用

AIベンチャーのSakana AIは、小規模言語モデル(SLM)「TinySwallow-1.5B」を開発したと発表した。大規模言語モデル(LLM)の知識を効率的にSLMに転移できる新技術「TAID」を開発し、これを利用し作成した。

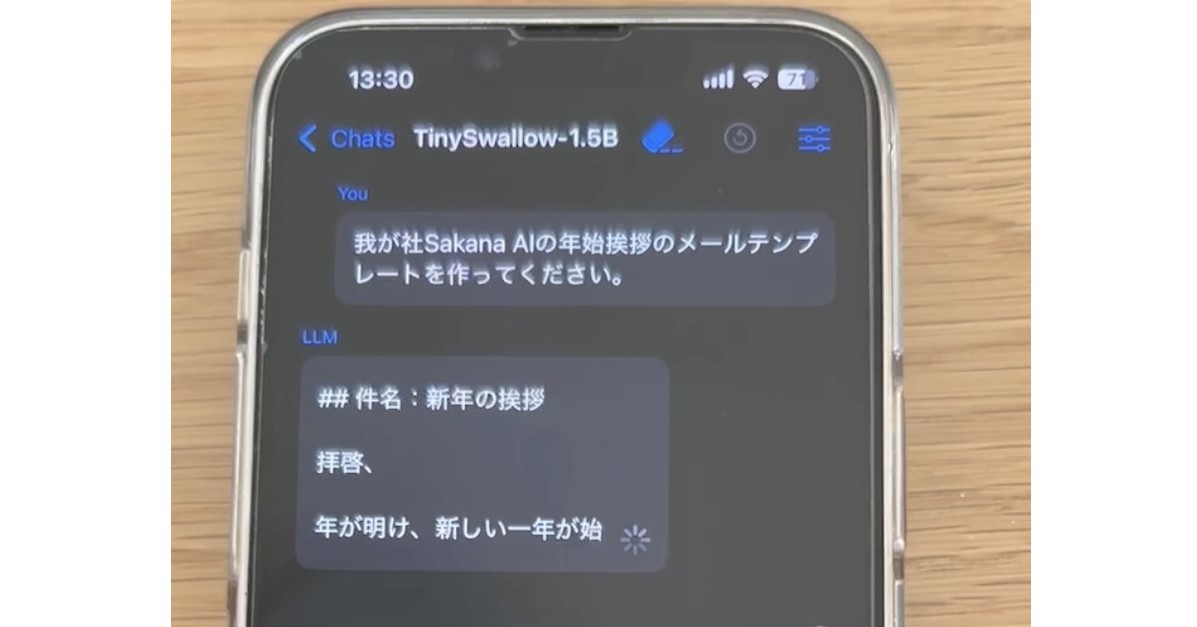

AIベンチャーのSakana AI(東京都港区)は1月30日、小規模言語モデル(SLM)「TinySwallow-1.5B」を開発したと発表した。大規模言語モデル(LLM)の知識を効率的にSLMに転移できる新技術「TAID」(Temporally Adaptive Interpolated Distillation)を利用し作成したSLMで、デモ動画ではiPhone 14上で高速動作する様子を確認できる。

TinySwallow-1.5Bは、15億パラメータを持つ小型モデルで、320億パラメータの大規模言語モデル(LLM)から知識を効率的に移行。

米Metaの「Llama-3.2-1B」や米Googleの「Gemma-2-2B」などと比較しても高い日本語性能を記録。iPhone 14上でオフラインでの高速文章生成が可能。知識蒸留は、高性能な教師モデルの出力を生徒モデルに学習させる手法。TAIDはこのプロセスを段階的に行い、生徒モデルの学習度に応じて中間教師モデルを用意することで、能力差を埋めることを目指す。

TAIDを使用することで、生徒モデルの性能が向上することが実験で確認されている。Sakana AIは、SLMの研究開発を今後も進めていく意向を示している。

この新しいAIモデルは、特にスマートフォンなどのエッジデバイスでの利用に適しており、実用的なアプリケーションが期待されています。