AIモデルが学習した有害知識を忘れさせる新たな手法。情報漏洩の抑止に期待

北陸先端科学技術大学院大学の研究グループは、大規模言語モデル(LLM)が学習した有害な知識を消去する新たな手法「Adaptive RMU」を発表した。

2025年5月1日、北陸先端科学技術大学院大学の研究グループは、大規模言語モデル(LLM)が学習した有害な知識を効果的に忘れさせる新手法「Adaptive RMU」を発表しました。この技術は、情報漏洩のリスクを低減することが期待されています。

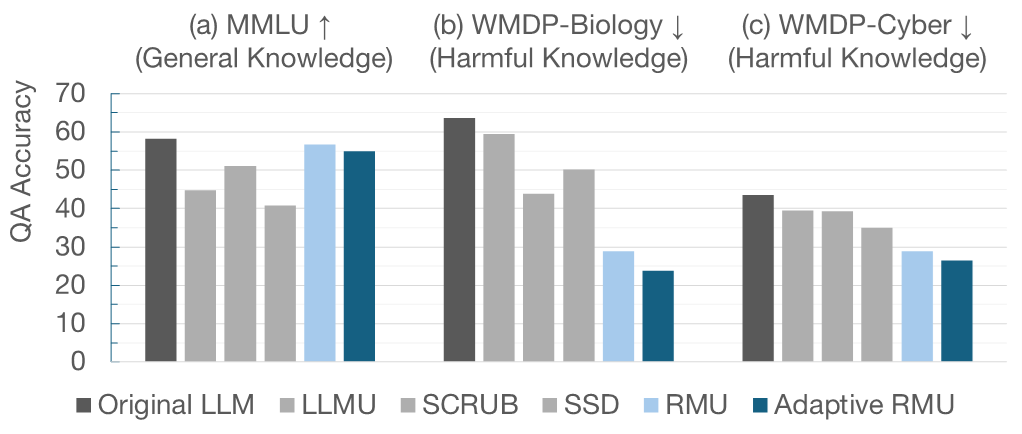

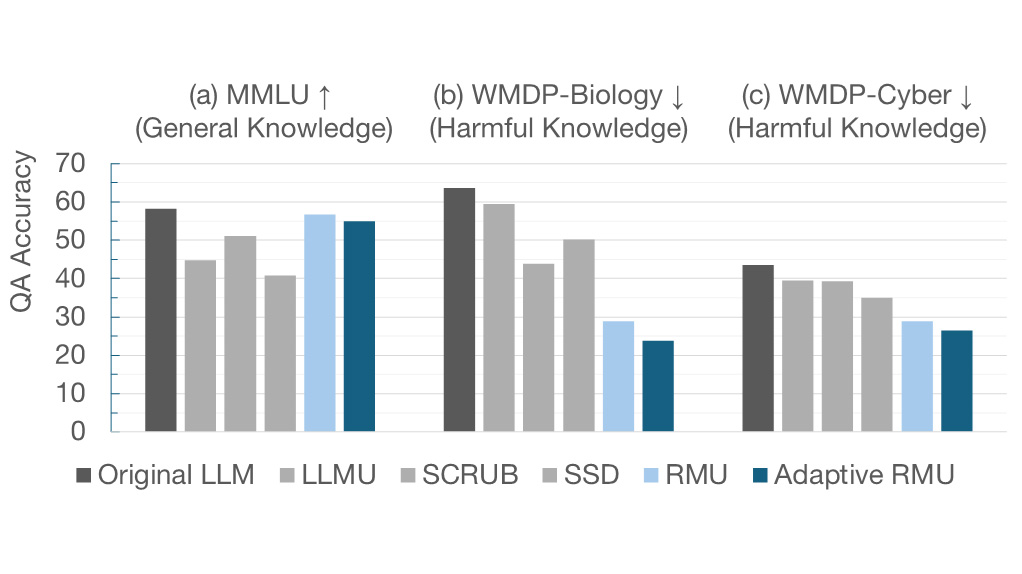

Adaptive RMUは、従来の「Representation Misdirection for Unlearning」(RMU)を改良したもので、知識忘却のための内部表現をランダム化し、手動で調整していた制御パラメータを自動化することで最適化コストを大幅に削減しました。

この手法は、LLMの一般的な言語理解能力をほとんど損なわずに、有害情報に関する質問の正答率を大幅に低下させることが実証されており、チャットボットや自動応答システムなどでの個人情報や機密情報の漏洩リスクを低減することが期待されています。

また、忘却後のLLMに対する「知識復元攻撃」に対しても高い防御性能を実現しています。

JAIST 北陸先端科学技術大学院大学

https://www.jaist.ac.jp/index.html

大規模言語モデルの効率的な知識”忘却”技術を提案 -安全なAIの実現に大きな一歩- | JAIST 北陸先端科学技術大学院大学

https://www.jaist.ac.jp/whatsnew/press/2025/04/30-2.html