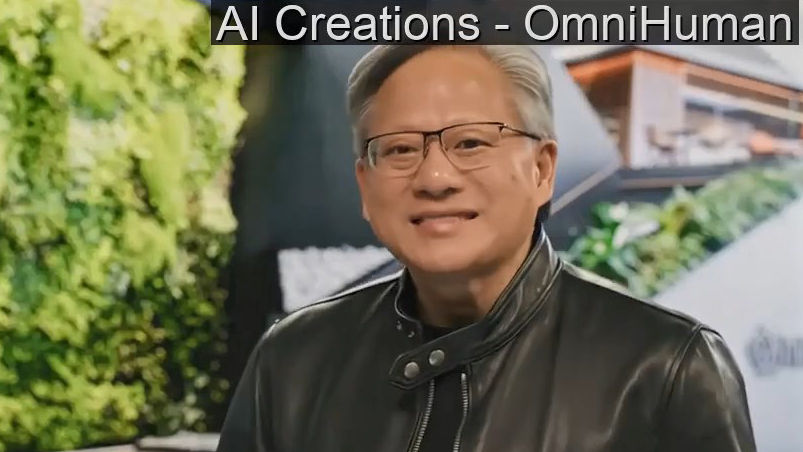

もう何も信じられないレベルでリアルなディープフェイク動画が作れるByteDanceのAI「OmniHuman-1」が登場

1枚の写真から人が自然に話したり、歌ったり、動いたりするリアルな動画を出力するAIシステム「OmniHuman-1」を中国のByteDanceが発表しました。

1枚の写真から人が自然に話したり、歌ったり、動いたりするリアルな動画を出力するAIシステム「OmniHuman-1」を中国のByteDanceが発表しました。

ByteDanceは2025年2月3日に、エンドツーエンドのマルチモーダル条件付き人間動画生成フレームワークであるOmniHumanを発表しました。このモデルは、1枚の人間の画像とモーションシグナル、例えば音声のみ、映像のみ、またはそれらの組み合わせから、人物の映像を生成することが可能です。

発表によると、OmniHumanはテキスト、音声、体の動きなど複数の入力を組み合わせたアプローチと、1万8700時間を超える人物の動画データでトレーニングされているとのこと。

このようなAIモデルの進歩は、映像コンテンツにイノベーションをもたらすと期待されている一方で、扇動や詐欺目的のディープフェイク動画による影響がさらに激化すると危惧する声もあります。例えば、2024年に行われた台湾の選挙では、中国共産党系の団体が親中派の候補者を支持するようなAI生成コンテンツを拡散したことが報告されています。

ITニュースサイト・VentureBeatはOmniHumanについて、「業界の専門家は、こうした技術がエンターテインメント制作、教育コンテンツ制作、デジタル通信に変革をもたらす可能性があると述べています。しかし、欺瞞(ぎまん)目的で合成メディアを作成するという悪用の可能性についての疑念も生じています」とコメントしました。

omnihuman-lab.github.io/

https://omnihuman-lab.github.io/